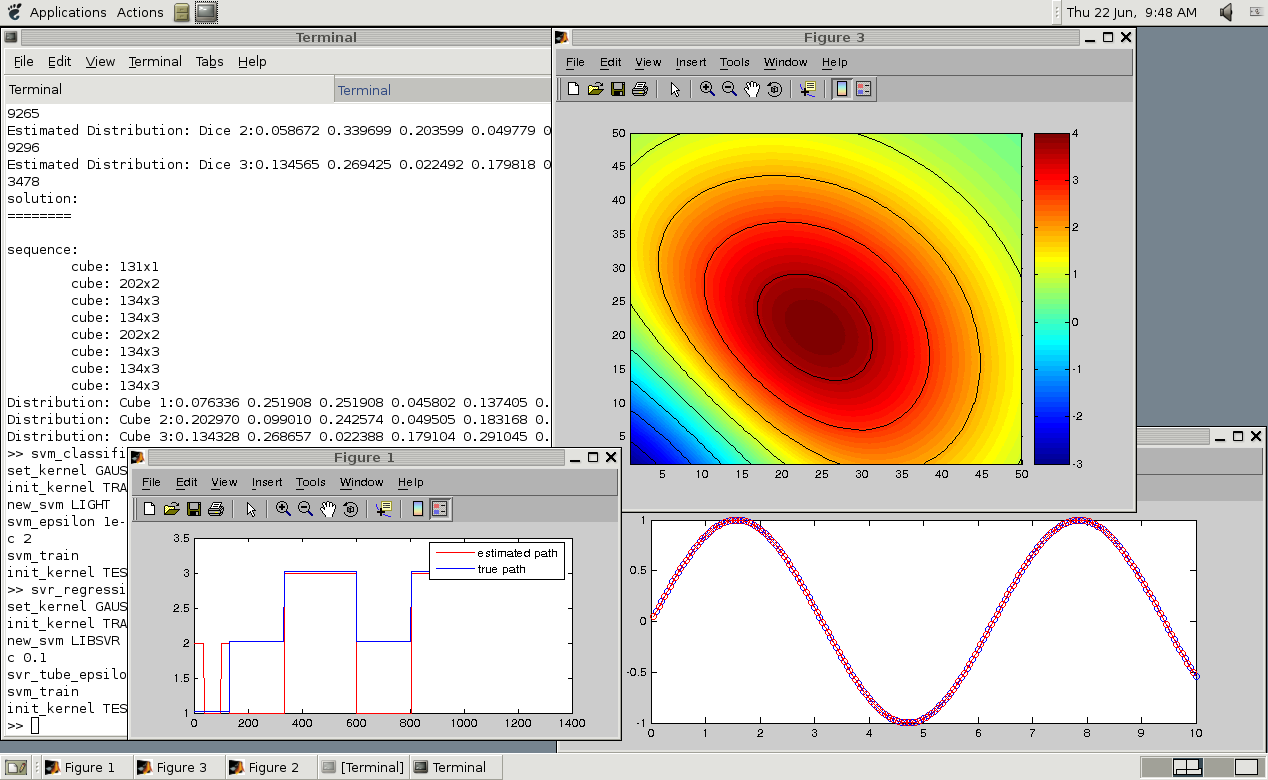

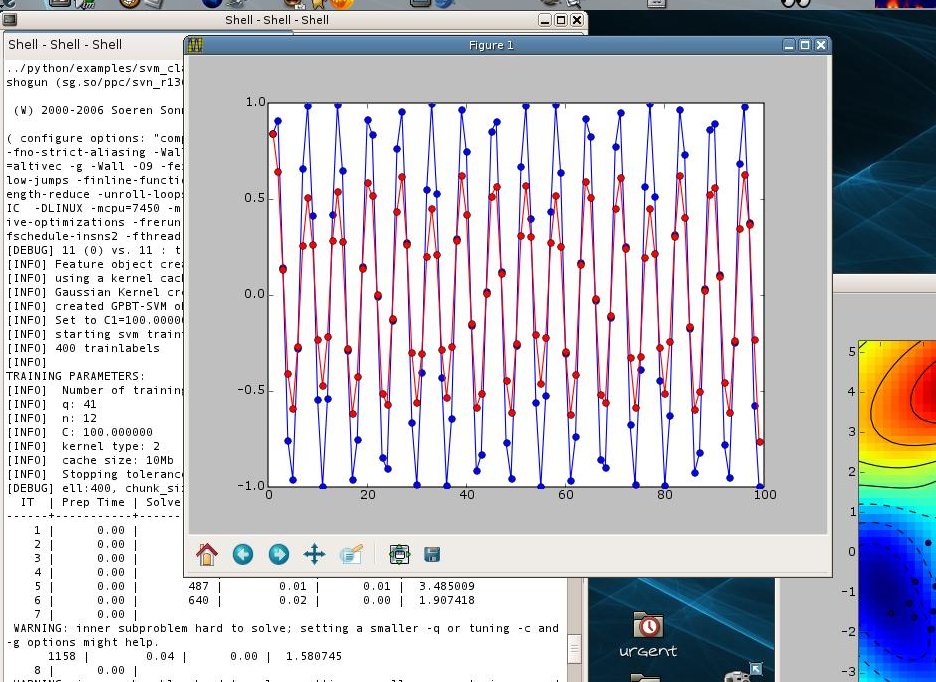

SHOGUN è un progetto open source progettato dalla offset per fornire una serie di strumenti di apprendimento automatico rivolta ai metodi kernel su larga scala, e specificamente progettato per Support Vector Machines (SVM). Il software può essere facilmente utilizzato all'interno di vari linguaggi di programmazione, tra cui C, C ++, Python, Octave, Matlab, Java, C #, Ruby, Lua, UNIX Shell, e R.

L'applicazione offre un oggetto standard SVM (Support Vector Machines) che può interfacciarsi con varie implementazioni SVM. Esso comprende anche molti metodi lineari, come la Programmazione Lineare macchina (LPM), Analisi Discriminante Lineare (LDA), (Kernel) Percettroni, così come alcuni algoritmi che possono essere utilizzati per addestrare nascosto Markov models.Features a una funzionalità glanceKey includono uno Classificazione Classe, la classificazione, la regressione, l'apprendimento di uscita strutturato, pre-processing multiclasse, strategie di selezione modelli incorporati, framework di test, sostegno all'apprendimento larga scala, multitask apprendimento, adattamento di dominio, la serializzazione, codice parallelizzate, misure di performance, cresta kernel di regressione, vettore supporto regressione e processi gaussiani.

Inoltre, supporta più kernel di apprendimento, tra cui q-norma MKL e multiclasse MKL, supporta i Naive Bayes, regressione logistica, LASSO, k-NN e gaussiana processo classificatori classificazione, supporta macchine programmazione lineare, catene LDA, Markov, modelli nascosti di Markov, PCA, kernel PCA, Isomap, scaling multidimensionale, embedding lineari a livello locale, la mappa di diffusione, l'allineamento spazio tangente locale, così come eigenmaps Laplaciane.

Inoltre, è dotato di Barnes-Hut t-END supporto, kernel normalizzatore, kernel sigma, kernel di stringa, polinomiale, lineare e kernel gaussiana, clustering gerarchico, k-means, ottimizzazione BFGS, discesa del gradiente, attacchi di CPLEX, attacchi a Mosek, etichetta apprendimento sequenza, fattore di apprendimento grafico, SO-SGD, latente SO-SVM e dati sparsi representation.Under il cofano e availabilitySHOGUN è orgogliosamente scritti in Python e C ++ linguaggi di programmazione, il che significa che & rsquo; s compatibile con qualsiasi sistema operativo GNU / Linux dove esistono Python e GCC. E 'disponibile per il download come un archivio fonte universale, in modo da poter installare su qualsiasi sistema operativo basato sul kernel Linux

Cosa c'è di nuovo in questa versione:.

- Caratteristiche:

- Supporto completo python3 ora

- Aggiungi mini-lotti k-means [Parijat Mazumdar]

- Aggiungi k-means ++ [Parijat Mazumdar]

- Aggiungi kernel stringa sub-sequenza [lambday]

- Bugfix:

- Compila correzioni per imminente swig3.0

- Speedup per il processo gaussiana 'applicare ()

- migliorare i controlli dell'unità di prova / integrazione

- libbmrm memoria non inizializzata legge

- libocas memoria non inizializzata legge

- Octave 3.8 compila correzioni [Orion Poplawski]

- errore Fix java compilazione modulare [Bjoern Esser]

Cosa c'è di nuovo nella versione 3.1.1:

- Fissare compilazione errore si verifica con CXX0X

- Bump versione dei dati di versione richiesta

Cosa c'è di nuovo nella versione 3.1.0:

- Questa versione contiene per lo più bugfix, ma dispongono anche di miglioramenti .

- . Il più importante, un paio di perdite di memoria legati ad applicare () sono stati risolti

- La scrittura e la lettura delle caratteristiche Shogun come protobuf oggetti è ora possibile.

- personalizzati Kernel matrici possono essere ora 2 ^ 31-1 * 2 ^ 31-1 dimensioni.

- quaderni multiclasse ipython sono stati aggiunti, e gli altri hanno migliorato.

- Lascia-one-out crossvalidation è ora conveniente supportata.

Cosa c'è di nuovo nella versione 2.0.0:

- Esso comprende tutto ciò che è stata effettuata prima e durante il Google Summer of Code 2012.

- Gli studenti hanno attuato varie nuove funzionalità, come strutturato di apprendimento uscita, processi gaussiani, latente variabili SVM (e di apprendimento uscita strutturato), test statistici in kernel spazi che riproducono, vari algoritmi di apprendimento multitask, e vari miglioramenti di usabilità, per citarne alcuni.

Cosa c'è di nuovo nella versione 1.1.0:

- Questa versione ha introdotto il concetto di "trasformatori", che consente di costruire incastri di funzioni arbitrarie.

- Esso include anche un paio di nuove tecniche di riduzione dimensione e significativi miglioramenti delle prestazioni del toolkit riduzione dimensionalità.

- Altri miglioramenti includono una significativa accelerazione compilation, vari bugfix per le interfacce modulari e algoritmi, e migliorate Cygwin, Mac OS X, e clang compatibilità ++.

- Github Issues è ora utilizzato per bug e problemi di tracciamento.

Cosa c'è di nuovo nella versione 1.0.0:

- Questa versione dispone di interfacce alle nuove lingue tra cui Java, C #, Ruby, e Lua, un quadro di selezione del modello, molte tecniche di riduzione dimensione, gaussiana stima miscela modello, e di un quadro di apprendimento online a tutti gli effetti.

Cosa c'è di nuovo in versione 0.10.0:

- Caratteristiche:

- la serializzazione di oggetti derivanti da CSGObject, vale a dire tutti gli oggetti Shogun (SVM, Kernel, Caratteristiche, preprocessori, ...) come ASCII, JSON, XML e HDF5

- Crea SVMLightOneClass

- Aggiungi CustomDistance in analogia con kernel personalizzato

- Aggiungi HistogramIntersectionKernel (grazie Koen van de Sande per la patch)

- Supporto 2010a Matlab

- supporto modulare SpectrumMismatchRBFKernel (grazie Rob Patro per la patch)

- Aggiungi ZeroMeanCenterKernelNormalizer (grazie Gorden Jemwa per la patch)

- Supporto Swig 2.0

- Bugfix:

- Personalizza kernel può ora essere & gt; 4G (grazie Koen van de Sande per la patch)

- Imposta locale C all'avvio in init_shogun per evitare incompatiblies con carri ascii e fprintf

- Compila correzione quando il conteggio dei riferimenti è disabilitato

- set_position_weights correzione di kernel WD (riportato da Dave duVerle)

- set_wd_weights correzione di kernel wd.

- Fix Crasher in SVMOcas (segnalato da Yaroslav)

- Pulitura e API Modifiche:

- Rinominato SVM_light / SVR_light per SVMLight etc.

- Rimuovi C prefisso davanti nomi di classi non serializzabili

- Goccia CSimpleKernel ed introdurre CDotKernel come classe base. È necessario in questo modo tutti i kernel basati dot-prodotto può essere applicato sulla parte superiore del DotFeatures e solo una singola implementazione di tali kernel.

Cosa c'è di nuovo nella versione 0.9.3:

- Caratteristiche:

- Experimental lp-norma MCMKL

- Nuovi Noccioli: SpectrumRBFKernelRBF, SpectrumMismatchRBFKernel, WeightedDegreeRBFKernel

- kernel WDK supporta aminoacidi

- String supportano ora aggiungere operazioni (e la creazione di

- Supporto python-dbg

- Consenti galleggianti come input per il kernel personalizzato (e matrici & gt; 4GB di dimensioni)

- Bugfix:

- Static fix collegamento.

- Fissare add_to_normal del kernel lineare sparse

- Pulitura e API Modifiche:

- Rimuovi funzione init () in misure di performance

- Regolare .so suffisso per python e utilizzare distutils pitone per capire installare percorsi

Caratteristiche

Cosa c'è di nuovo nella versione 0.9.2:

- Caratteristiche:

- Lettura diretta e la scrittura di file in base ASCII / File binari / HDF5.

- Implementato più normalizzatore kernel compito.

- Implementare kernel SNP.

- Implementare termine per libsvm / libsvr.

- Integrare Elastic Net MKL (grazie Ryoata Tomioka per la patch).

- implementare funzionalità Hashed WD.

- Implementare hash Caratteristiche Sparse Poly.

- Integrare liblinear 1.51

- LibSVM ora può essere addestrato con pregiudizi disattivata.

- Aggiungi funzioni per impostare / ottenere globale e locale io / parallelo / ... oggetti.

- Bugfix:

- Fix set_w () per classificatori lineari.

- Static Octave, interfacce Python, cmdline e Modular Python Compilare pulito in Windows / Cygwin nuovamente.

- In interfacce statiche test potrebbe fallire se non fatto immediatamente dopo l'allenamento.

I commenti non trovato